Este avance permitiría que personas mentalmente conscientes con dificultades físicas para hablar puedan comunicarse eficazmente.

Investigadores de la Universidad de Texas en Austin, (UT Austin) desarrollaron un sistema de inteligencia artificial (IA) capaz de traducir la actividad cerebral de una persona en flujo continuo de texto. La actividad cerebral mientras un paciente escucha una historia o piensa que cuenta una historia podría ser convertido en texto, gracias a este sistema denominado decodificador semántico. Este avance podría facilitar la comunicación con personas con dificultades físicas para hablar, por ejemplo, derivado de derrames cerebrales.

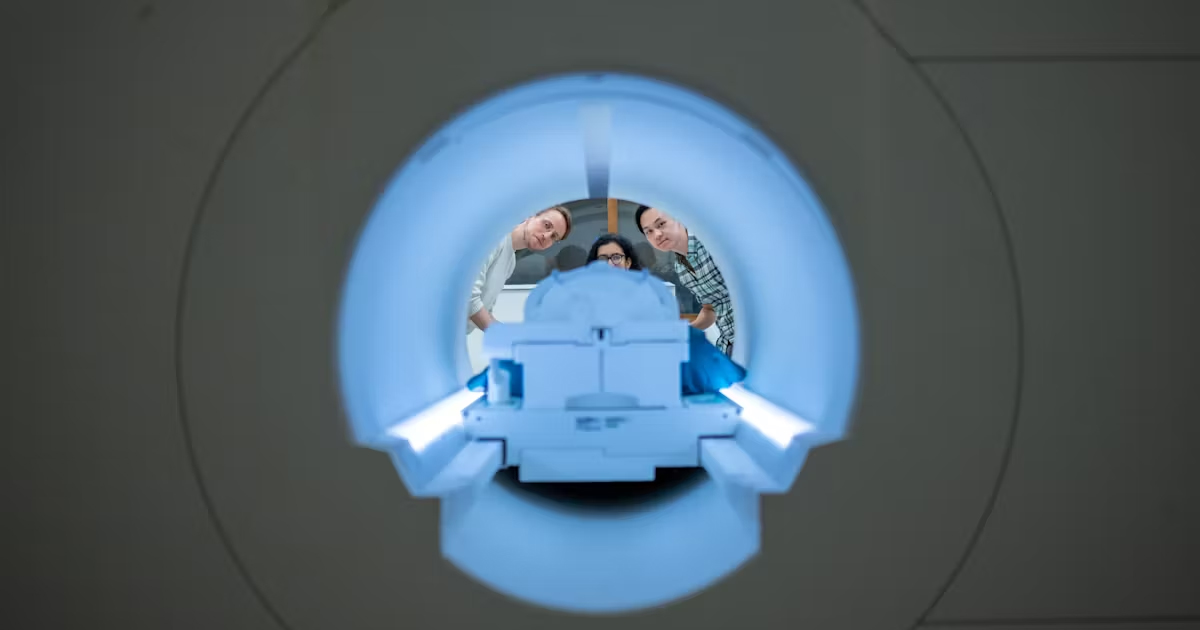

El estudio Reconstrucción semántica de lenguaje continuo a partir de grabaciones cerebrales no invasivas fue publicado en la revista Nature Neuroscience, en el cual se detallan aspectos técnicos sobre este sistema. El estudio detalla que se trata de un decodificador no invasivo que reconstruye el lenguaje continuo a partir de representaciones semánticas corticales, las cuales fueron registradas utilizando imágenes de resonancia magnética funcional.

Gracias a los avances en las grabaciones cerebrales, este decodificador semántico genera secuencias de palabras inteligibles que recuperan el significado del habla percibida, el habla imaginada e incluso videos silenciosos, es decir este sistema puede aplicarse a múltiples tareas. Por otra parte, el decodificador fue probado por los investigadores y los investigadores descubrieron que el lenguaje continuo se puede decodificar por separado de múltiples regiones cerebrales.

Mientras eran escaneados los participantes escuchaban o pensaban historias o incluso eran grabados observando cuatro videos cortos y silenciosos. De esta forma el decodificador semánticas pudo usar su actividad cerebral para describir con precisión el contenido de los videos.

“Estamos logrando que el modelo decodifique un lenguaje continuo durante largos períodos de tiempo con ideas complicadas”, explicó Alex Huth profesor asistente de neurociencia y ciencias de la computación de UT Austin y uno de los autores del estudio.

El trabajo realizado por los investigadores se basa en parte en un modelo transformador, similar a los modelos generativos que impulsan ChatGPT o Bard de Google. Además, como se mencionó anteriormente, a diferencia de otros sistemas de decodificación de idiomas, el sistema realizado por los investigadores de UT Austin, no requiere que los pacientes utilicen implantes quirúrgicos, volviéndolo un método no invasivo. Asimismo, el extenso entrenamiento del decodificador permite el uso de los escáneres de resonancia magnética.

No obstante, el resultado no se trata de una transcripción perfecta de palabra por palabra, sino que es un texto que se asemeja con bastante precisión a los significados previstos de las palabras originales. Algunos de los experimentos realizados mostraron cómo los pensamientos de algunos participantes fueron traducidos por el decodificador. Por ejemplo, una oradora dijo: “Todavía no tengo mi licencia de conducir” frase que fue traducida como “Ella ni siquiera ha comenzado a aprender a conducir todavía”.

Aunque este sistema no es práctico para su uso fuera del laboratorio donde se realizaron los experimentos, los investigadores consideran que es posible transferir este trabajo a otros sistemas de imágenes cerebrales portátiles.

Finalmente, los investigadores detallan que la decodificación solamente funciona con participantes cooperativos y que participaron voluntariamente en el entrenamiento del decodificador. De hecho, los resultados para las personas en las que no se había entrenado el decodificador fueron ininteligibles.

“Nos tomamos muy en serio las preocupaciones de que podría usarse para malos propósitos y hemos trabajado para evitarlo. Queremos asegurarnos de que las personas solo usen este tipo de tecnologías cuando quieran y que les ayuden”, explicó Jerry Tang estudiante de doctorado en ciencia de la computación en UT Austin y director del estudio.