Investigadores del MIT investigan acerca de cómo se pueden probar los modelos de AI para garantizar su seguridad y evitar que revelen datos sobre la salud de los pacientes.

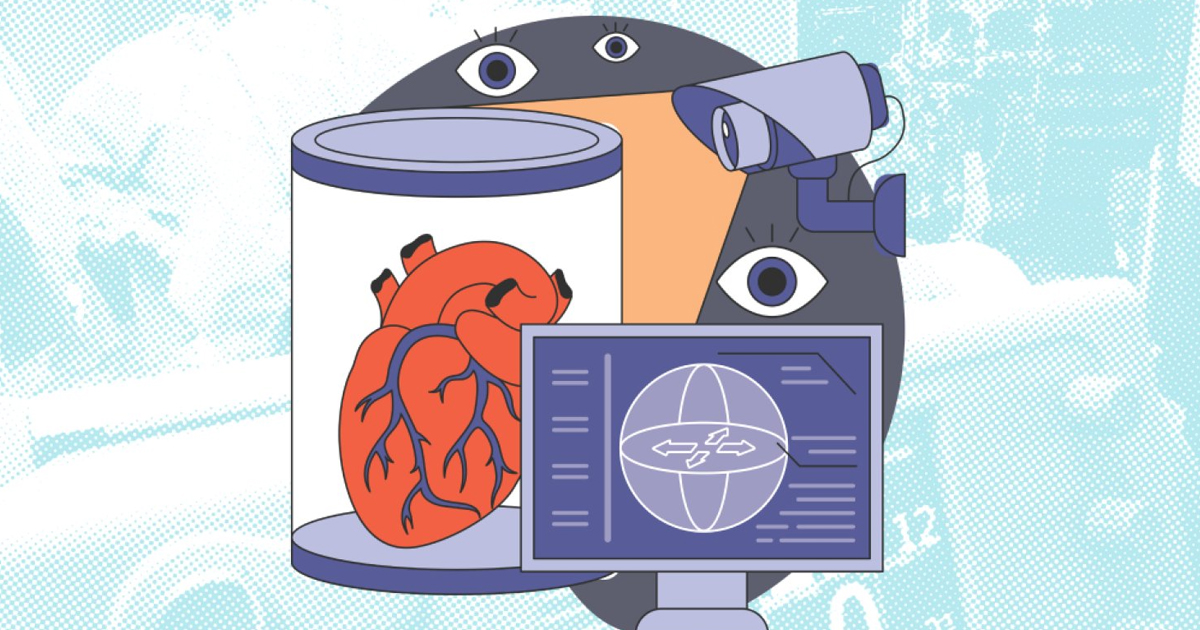

The modelos de inteligencia artificial (AI) que analizan expedientes médicos electrónicos prometen transformar la atención sanitaria, al ayudar a médicos e instituciones a predecir enfermedades, optimizar tratamientos y mejorar la calidad del cuidado. Sin embargo, un nuevo estudio liderado por investigadores del MIT advierte que estos sistemas también pueden representar un riesgo serio para la privacidad de los pacientes si “memorizan” información sensible en lugar de solo aprender patrones generales.

El problema surge cuando estos llamados modelos fundacionales, que son entrenados con grandes volúmenes de historiales clínicos, no solo aprenden tendencias médicas, sino que llegan a retener detalles específicos de personas reales. Aunque los datos estén legalmente desidentificados, los autores explican que, bajo ciertas condiciones, la AI podría revelar diagnósticos, tratamientos o incluso permitir inferir si una persona formó parte del conjunto de datos de entrenamiento.

Para enfrentar este reto, el equipo propone un marco de evaluación que permite medir, de forma práctica, qué tanto riesgo de privacidad implica un modelo médico. A diferencia de estudios anteriores centrados en ataques teóricos, esta investigación se enfoca en situaciones reales de uso clínico: qué puede ocurrir si alguien interactúa con el sistema usando solo preguntas o fragmentos de información aparentemente inocentes.

Los científicos diseñaron seis pruebas que permiten analizar dos tipos de “memorización”. La primera ocurre cuando el modelo genera respuestas que reproducen información cercana a registros reales; la segunda se da cuando los datos quedan ocultos en las representaciones internas del sistema, pero aun así pueden ser extraídos mediante técnicas especializadas. Estas evaluaciones buscan distinguir entre lo que es una generalización útil, como lo es reconocer síntomas comunes de una enfermedad, y lo que sería una filtración indebida de datos personales.

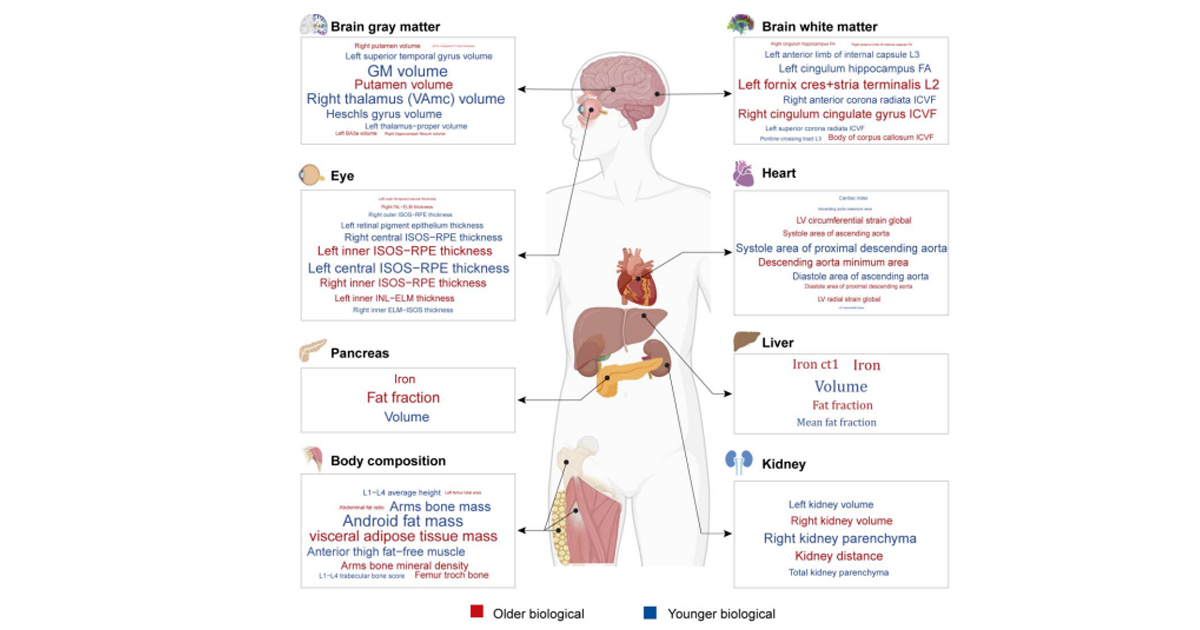

Uno de los hallazgos más importantes es que el riesgo no depende únicamente de cuánto recuerda el modelo, sino de qué tipo de información llega a revelar. Por ejemplo, reproducir resultados rutinarios de laboratorio tiene un impacto mucho menor que exponer diagnósticos asociados con estigmas sociales, como trastornos mentales, consumo de sustancias o enfermedades infecciosas. En estos casos, incluso una pequeña filtración puede tener consecuencias graves para la vida personal y laboral de un paciente.

El estudio también pone atención especial en los grupos vulnerables. Las personas con enfermedades raras o pertenecientes a subpoblaciones pequeñas corren un mayor riesgo de ser identificadas indirectamente, aun cuando sus datos hayan sido anonimizados. Los investigadores muestran que, si un modelo asocia información sensible con características poco comunes, el peligro de reidentificación aumenta de forma considerable.

A partir de estas observaciones, el equipo propone que la evaluación de modelos médicos no se limite a medir su precisión clínica, sino que incluya auditorías sistemáticas de privacidad antes de su implementación. Esto implica analizar cómo responden a distintos tipos de consultas, qué tan fácil sería extraer información sensible y si existen diferencias de riesgo entre distintos grupos de pacientes.

Los autores subrayan que la inteligencia artificial puede ser una aliada poderosa para la medicina, pero solo si se desarrolla con responsabilidad. En un contexto donde la confianza es clave para que las personas compartan sus datos de salud, garantizar que los sistemas no expongan información privada es tan importante como lograr diagnósticos más precisos.

Finalmente, el estudio pone a disposición de la comunidad científica un conjunto de herramientas de código abierto para que hospitales, desarrolladores y reguladores puedan evaluar por sí mismos los riesgos de memorización. La meta es clara: avanzar hacia modelos de AI que no solo sean inteligentes, sino también seguros y respetuosos de la privacidad de quienes confían en ellos para cuidar su salud.