Investigadores desarrollan un sistema integral para guiar la implementación, supervisión y gestión de riesgos de herramientas de IA en entornos sanitarios.

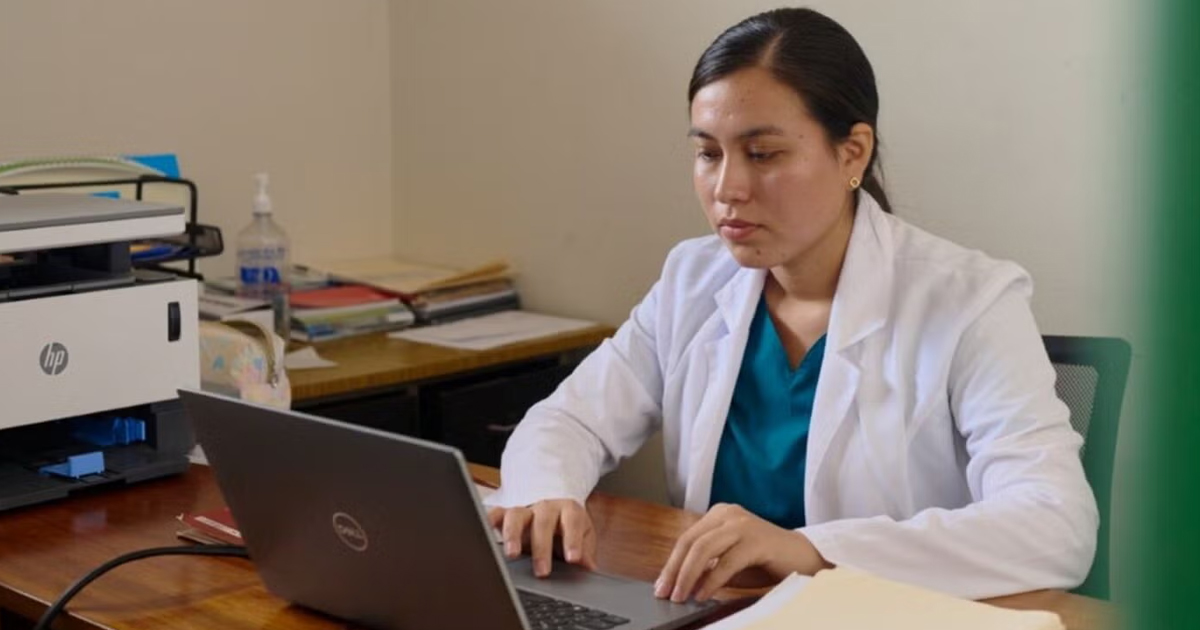

La creciente incorporación de inteligencia artificial (IA) en la atención médica promete mejoras significativas en diagnósticos, tratamientos y eficiencia. Sin embargo, su uso apresurado sin una evaluación rigurosa puede generar riesgos éticos, clínicos y de equidad. Para enfrentar este reto, un equipo multidisciplinario creó el marco FAIR-AI o Framework for the Appropriate Implementation and Review of AI, que ofrece a los sistemas de salud una guía detallada para la evaluación previa y el monitoreo posterior de estas tecnologías.

El estudio, publicado en npj Digital Medicine, señala que muchos marcos de evaluación existentes carecen de directrices prácticas adaptadas a contextos reales. FAIR-AI se diseñó a partir de revisión de literatura, entrevistas con pacientes, clínicos, desarrolladores y líderes de salud, así como un taller de consenso con expertos en áreas como ética, regulación, ciencia de datos y atención clínica.

El marco propone una serie de elementos esenciales:

- Requisitos organizativos como principios rectores, declaraciones de ética en IA, equipos capacitados y herramientas para inventariar soluciones.

- Criterios de inclusión y exclusión para determinar qué herramientas deben ser evaluadas, incluyendo aplicaciones no clínicas y excluyendo dispositivos médicos ya regulados o proyectos de investigación con consentimiento informado.

- Proceso de revisión por niveles, que comienza con un cribado de bajo riesgo y, si es necesario, una evaluación en profundidad que examina aspectos de validación, utilidad, transparencia, equidad, cumplimiento normativo y posibles impactos negativos.

- Clasificación de riesgo en tres categorías: bajo, moderado o alto, con rutas de revisión más estrictas para las soluciones de mayor riesgo.

- Plan de IA segura, que incluye monitoreo continuo, transparencia para usuarios y, en casos de alto riesgo, etiquetas informativas sobre la herramienta.

Según los autores, este enfoque permite equilibrar innovación y seguridad, agilizando la adopción de soluciones con bajo potencial de daño, mientras se somete a un escrutinio riguroso a aquellas con implicaciones críticas. También destaca la necesidad de actualizar el marco regularmente para adaptarlo a los rápidos avances tecnológicos y regulatorios, así como la importancia de capacitar tanto a evaluadores como a usuarios finales.

FAIR-AI ofrece a los sistemas de salud una plantilla adaptable para implementar y vigilar la IA de manera segura y ética, preservando la confianza de pacientes y profesionales. Aunque su aplicación requiere recursos y compromiso institucional, sus creadores sostienen que es una vía viable para aprovechar el potencial de la inteligencia artificial sin comprometer la calidad ni la equidad en la atención médica.