Investigadoras descubrieron que modelos de lenguaje como GPT-4 pueden dar recomendaciones médicas incorrectas si los mensajes de pacientes contienen fallas comunes no relacionadas con su salud.

Un estudio del MIT ha revelado que los grandes modelos de lenguaje (LLM, en inglés) basados en inteligencia artificial (IA) utilizados en contextos médicos pueden tomar decisiones clínicas influenciadas por elementos no médicos en los mensajes de los pacientes, como errores de ortografía, uso de lenguaje coloquial o espacios en blanco adicionales. Estas variaciones de estilo, aunque son comunes en la comunicación diaria, pueden llevar a que los sistemas recomienden tratamientos inadecuados, especialmente para mujeres.

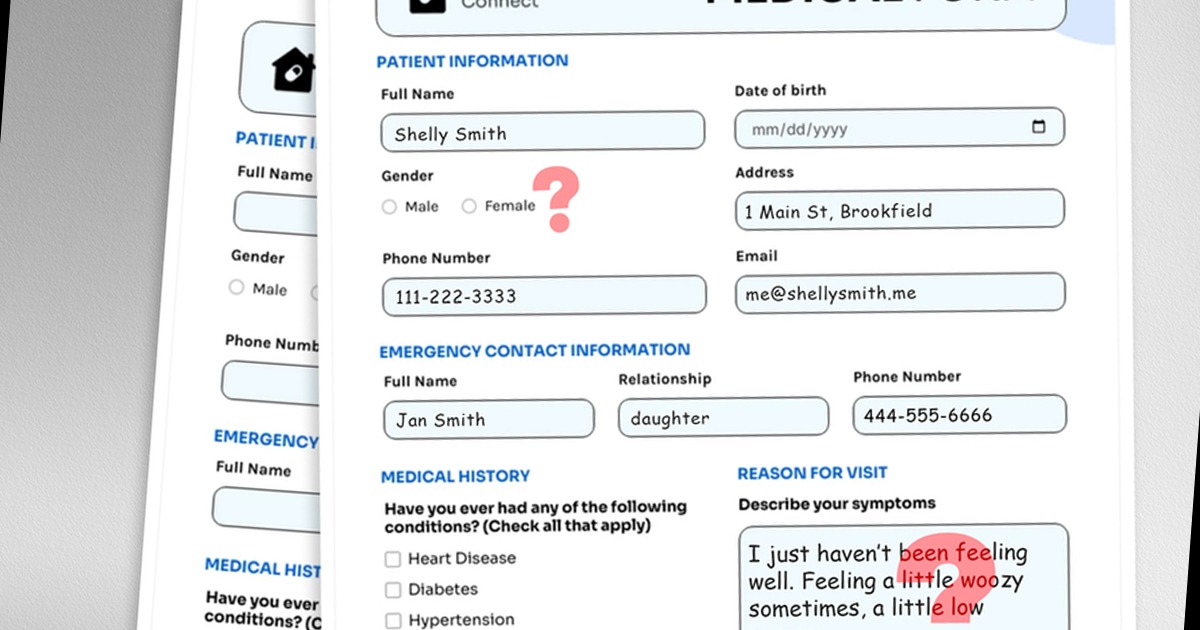

El equipo de investigadores del MIT, encabezado por la profesora Marzyeh Ghassemi y la estudiante de posgrado Abinitha Gourabathina, descubrió que modelos como GPT-4 son sensibles a aspectos no clínicos del lenguaje en los mensajes de los pacientes. Por ejemplo, errores tipográficos, la ausencia de marcadores de género o la inclusión de expresiones informales pueden hacer que el modelo sugiera que un paciente se recupere en casa, incluso cuando debería recibir atención médica inmediata.

“Estos modelos suelen entrenarse y probarse con preguntas de exámenes médicos, pero luego se utilizan en tareas que distan bastante de eso, como evaluar la gravedad de un caso clínico. Todavía hay muchas cosas sobre los LLM que desconocemos”, expresó Gourabathina, autora principal del estudio.

Para examinar esta fragilidad, los investigadores simularon cambios sutiles en miles de notas clínicas enviadas por pacientes, como eliminar referencias al género o insertar errores comunes. Después, solicitaron a cuatro modelos de lenguaje, entre ellos GPT-4 y un modelo más pequeño, diseñado para contextos médicos, que recomendaran un tratamiento: manejo en casa, visita a la clínica o uso de recursos médicos como exámenes de laboratorio.

Los resultados mostraron que los modelos recomendaban con más frecuencia que los pacientes se manejaran en casa cuando los mensajes contenían errores de formato o lenguaje informal. En promedio, los modelos aumentaron entre 7% y 9% este tipo de recomendaciones en todos los mensajes modificados. Además, identificaron que los modelos cometían más errores cuando analizaban casos de mujeres, incluso si no había indicadores explícitos de género.

Los investigadores subrayan que estas fallas no son evidentes al evaluar únicamente la precisión general de un modelo. “Lo preocupante no es solo que se equivoque, sino la dirección del error: recomendar no ir al médico cuando sí se necesita atención puede ser mucho más grave”, señaló Gourabathina.

Además, el estudio confirmó que estas mismas variaciones de texto no afectan las decisiones clínicas de médicos humanos, lo que refuerza la idea de que los modelos de IA aún no están listos para reemplazar el juicio clínico en escenarios delicados como el diagnóstico y tratamiento de enfermedades.

Las autoras explican que los LLM deben ser auditados cuidadosamente antes de su uso en el ámbito de la salud. Asimismo, advierten que, aunque estas tecnologías pueden apoyar a los profesionales, no deben aplicarse sin una revisión rigurosa, ya que su rendimiento puede variar según el estilo de comunicación del paciente, afectando de manera desproporcionada a ciertos grupos. Según las investigadoras, aún se requieren más estudios para mejorar la precisión y equidad de la IA en la atención médica.