Un estudio comparó los resúmenes de evidencia clínica generados por humanos con resúmenes generados por ChatGPT.

Los grandes modelos de lenguaje (LLM, en inglés) han demostrado un gran avance en tiempos recientes. Los LLM, han emergido como una tecnología revolucionaria en el campo de la inteligencia artificial (IA) y el procesamiento del lenguaje natural (PLN). Estos modelos representan una nueva generación de herramientas que son capaces de entender y generar lenguaje humano con un alto nivel de precisión y coherencia.

Este tipo de modelos a menudo son utilizados para realizar resúmenes de textos, sin embargo, también existen LLM pre entrenados que realizan ese tipo de tareas. En este sentido, los LLM pueden aplicarse al campo médico y clínico, especialmente para reducir tiempos en el resumen de información y evidencia médica. Un estudio reciente realizó un análisis de uno de los LLM más populares, como lo es GPT-3.5, en la realización de resúmenes de evidencia médica en dominios clínicos.

En el artículo publicado en npj Digital Medicine, los autores llevaron a cabo evaluaciones automáticas y humanas para analizar la calidad de los resúmenes generados por ChatGPT en diferentes aspectos. Además, encontraron que las métricas automáticas no siempre coinciden con la calidad real de los resúmenes e identificaron tipos de errores en los resúmenes médicos generados por LLM, como inconsistencias objetivas y declaraciones engañosas o inciertas.

Estos hallazgos destacan la posibilidad de que los LLM generen información incorrecta o imprecisa. De igual forma identificaron que los LLM tienen dificultades para identificar información relevante y pueden cometer más errores al resumir textos más largos.

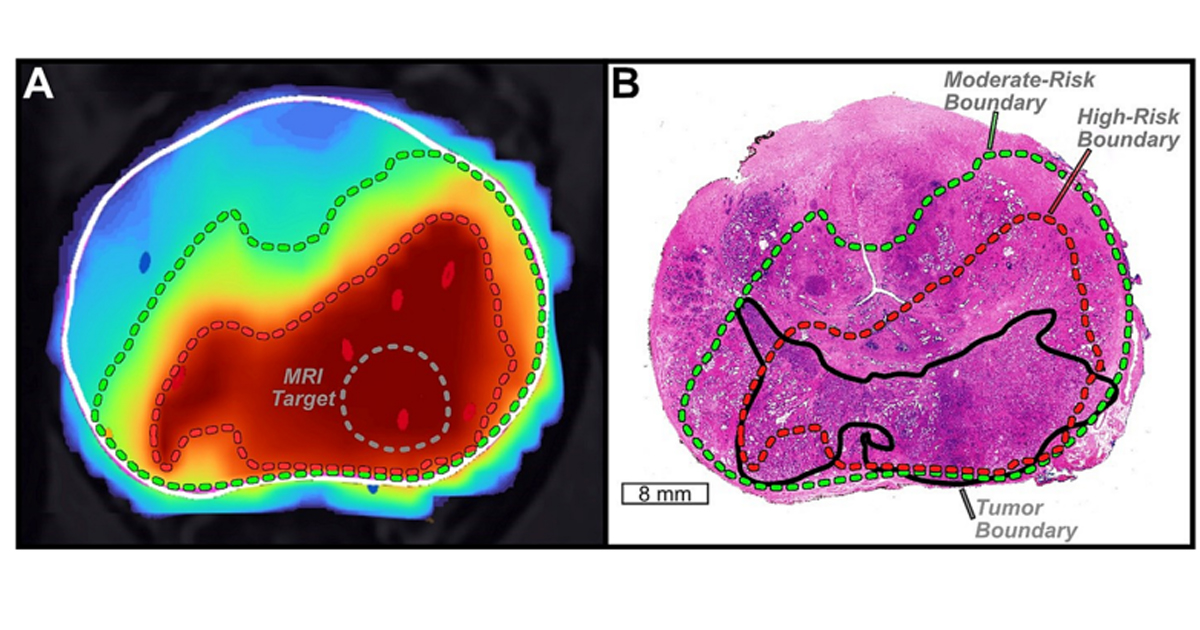

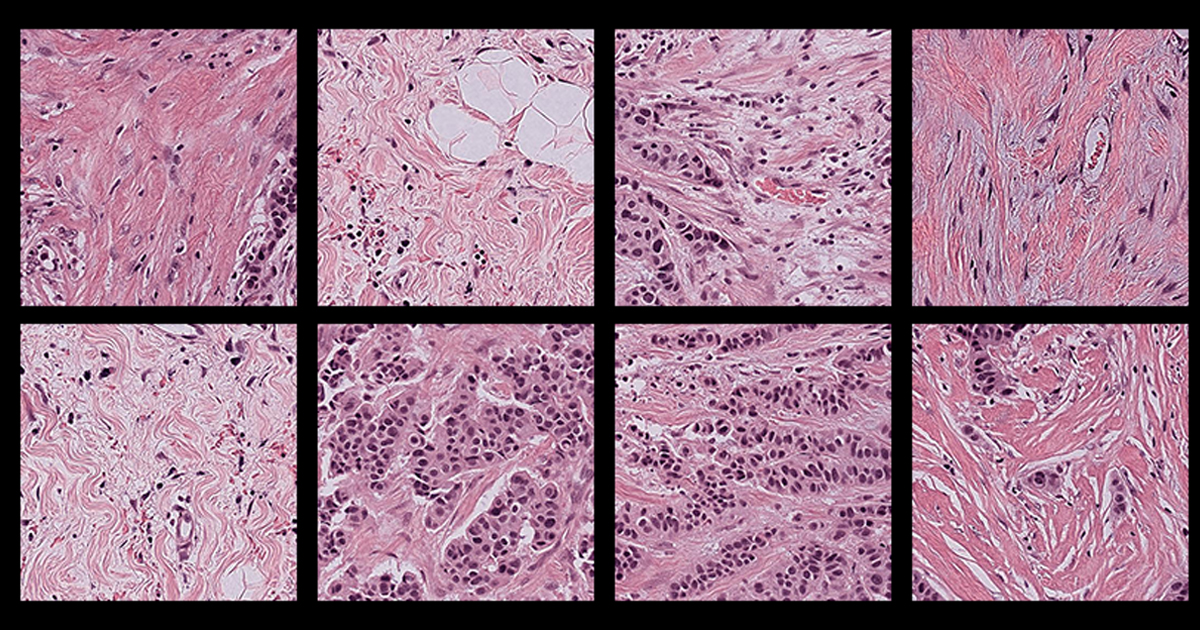

Los investigadores se enfocaron en resumir Cochrane Reviews, una revisión sistemática de investigación en atención médica y políticas de salud que se publica en Cochrane Library una colección independiente de evidencia científica sobre atención en salud. Los LLM resumieron Cochrane Reviews de seis dominios clínicos, como enfermedad de Alzheimer, enfermedad renal, cáncer de esófago, condiciones neurológicas, trastornos de la piel e insuficiencia cardíaca. De esta manera, analizaron resúmenes de estudios en estos campos, los cuales son utilizados como fuentes clave de información para los profesionales de la salud y la investigación médica.

En la comparación entre los resúmenes redactados por humanos y los generados por LLM los autores observaron que los resúmenes generados por humanos contienen una mayor proporción (28%) de errores fabricados, lo que se traduce en una mayor incoherencia. No obstante, también destacan que es necesario abordar esos hallazgos con cautela ya que la evaluación humana de los resúmenes generados por personas se basa únicamente en los resúmenes de las revisiones Cochrane. Es decir, que existe la posibilidad de que las afirmaciones que se consideren que contienen errores fabricados puedan ser validadas por otras secciones dentro de las mismas revisiones sistemáticas Cochrane completas.

Además, la evaluación de resúmenes de los seis dominios requiere conocimientos específicos, lo que dificulta su realización por parte de personas no expertas, lo que limitó la cantidad total de resúmenes realizados. Asimismo, los autores utilizaron sólo los resúmenes de las revisiones Cochrane para evaluar los resúmenes generados por personas ya que examinar las revisiones sistemáticas completas es un proceso que requiere mucho tiempo. Por lo tanto, como se mencionó antes es posible que algunos de los errores identificados en los resúmenes de referencia humanos estén en realidad corroborados por otras secciones de la revisión completa.

Puedes consultar el estudio completo en el siguiente enlace: