El estudio revela que algunos sistemas de IA en patología funcionan de manera desigual según características demográficas y propone una herramienta para reducir estas diferencias.

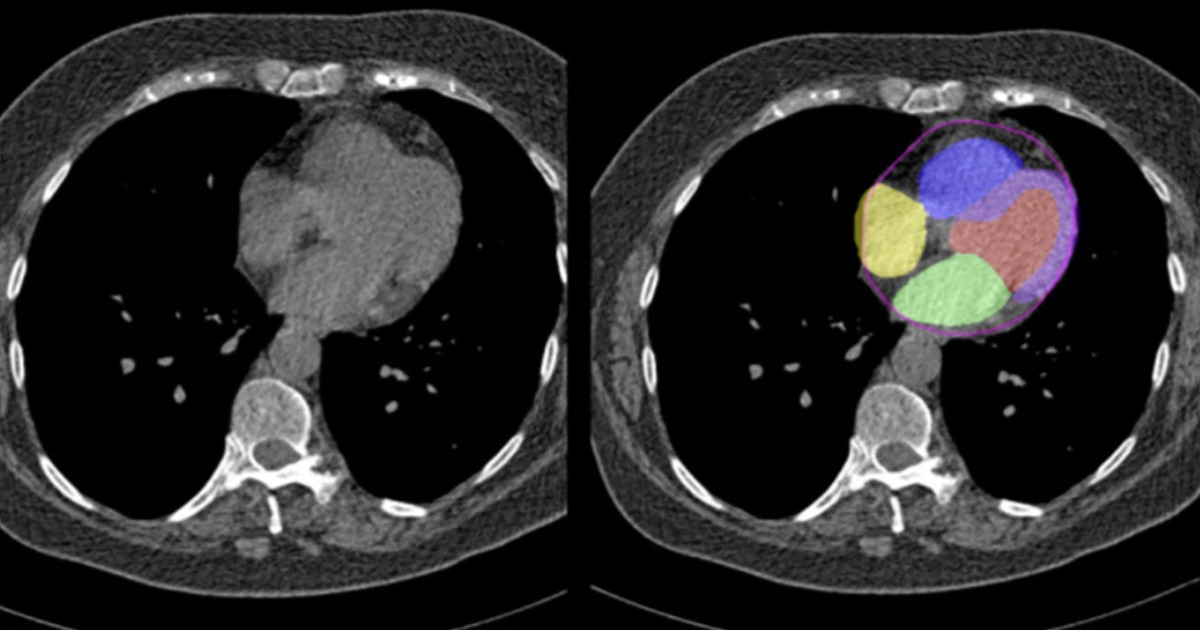

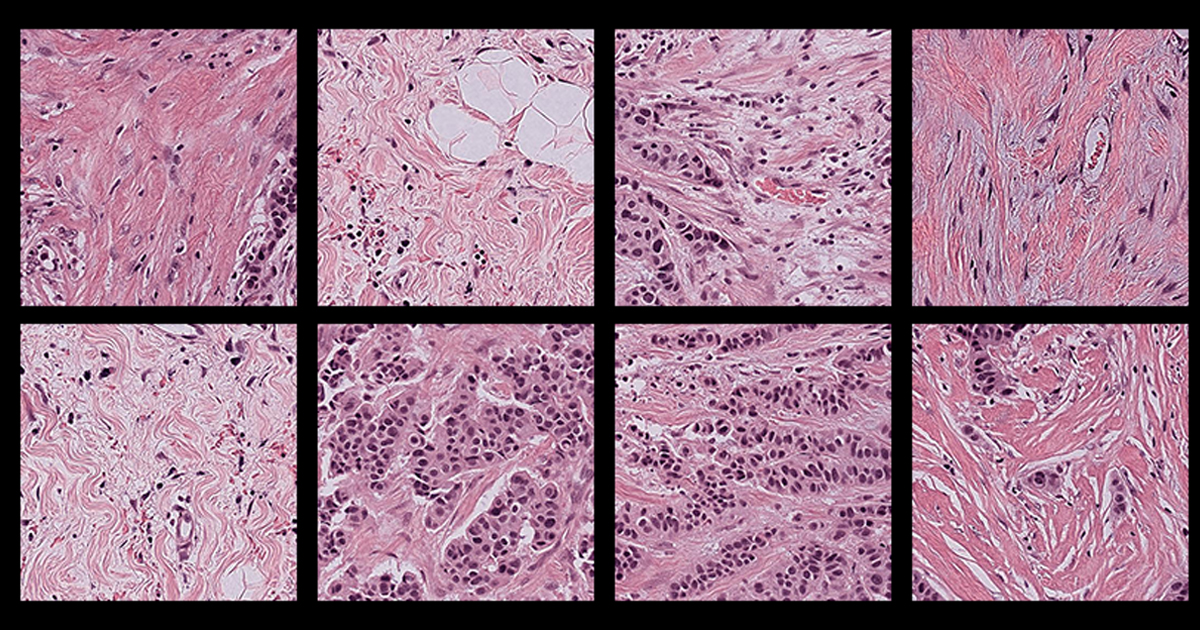

La patología ha sido durante décadas una pieza central en el diagnóstico y tratamiento del cáncer. A partir del análisis microscópico de muestras de tejido, los patólogos identifican el tipo y estadio de la enfermedad basándose exclusivamente en señales biológicas visibles. En principio, este proceso no ofrece información sobre la identidad o el origen de los pacientes. Sin embargo, una nueva investigación liderada por científicos de Harvard sugiere que los modelos de inteligencia artificial (IA) aplicados a patología no siempre funcionan con la misma objetividad.

El estudio, publicado en Cell Reports Medicine, analizó varios modelos de IA diseñados para diagnosticar distintos tipos de cáncer a partir de imágenes de tejido humano. Los investigadores encontraron que estos sistemas muestran diferencias significativas en su precisión diagnóstica dependiendo del género, la edad y la raza autorreportada de los pacientes.

Al evaluar cuatro modelos ampliamente utilizados, el equipo observó que el desempeño era desigual en casi un tercio de las tareas diagnósticas. Por ejemplo, algunos modelos tuvieron dificultades para diferenciar subtipos de cáncer de pulmón en pacientes afroamericanos y hombres, así como subtipos de cáncer de mama en personas más jóvenes. También se detectaron fallas en la identificación de cánceres de mama, riñón, tiroides y estómago en determinados grupos poblacionales.

“Leer información demográfica a partir de una lámina de patología se considera una ‘misión imposible’ para un patólogo humano, por lo que el sesgo en la IA fue una sorpresa para nosotros”, explicó Kun-Hsing Yu, autor principal del estudio y profesor asociado de informática biomédica en Harvard. Según Yu, esta falta de equidad puede afectar tanto la precisión diagnóstica como los resultados clínicos de los pacientes.

El análisis reveló que el sesgo no se explica únicamente por la falta de representatividad en los datos de entrenamiento. Aunque los modelos suelen entrenarse con más muestras de ciertos grupos, los investigadores observaron que incluso cuando los tamaños de muestra eran similares, el desempeño seguía siendo desigual. Una de las razones identificadas es que algunos tipos de cáncer son más frecuentes en determinadas poblaciones, lo que lleva a que los modelos “aprendan” patrones asociados a esos grupos y fallen cuando se enfrentan a otros menos representados.

Además, los sistemas de IA pueden captar diferencias moleculares sutiles vinculadas a ciertos grupos demográficos, como mutaciones genéticas más comunes en determinadas poblaciones. “Encontramos que, debido a lo poderosa que es la IA, puede diferenciar señales biológicas muy sutiles que no son detectables mediante la evaluación humana estándar”, señaló Yu. Esto puede llevar a que el modelo priorice señales relacionadas con la demografía en lugar de centrarse exclusivamente en la enfermedad.

Ante esto, el equipo desarrolló una nueva herramienta llamada FAIR-Path, diseñada para reducir el sesgo en los modelos de patología. Esta metodología ajusta el proceso de entrenamiento para que la IA se concentre en las diferencias relevantes entre tipos de cáncer y minimice la influencia de características demográficas. Al aplicar este enfoque, los investigadores lograron reducir las disparidades diagnósticas en aproximadamente un 88%.

“Demostramos que con un pequeño ajuste los modelos pueden aprender características más robustas, generalizables y justas para distintas poblaciones”, afirmó Yu. El hallazgo es relevante porque sugiere que es posible mejorar la equidad de la IA médica sin necesidad de contar, desde el inicio, con bases de datos perfectamente balanceadas.

De cara al futuro, el equipo de Harvard planea colaborar con instituciones de distintas regiones del mundo para evaluar el alcance del sesgo en contextos con diferentes perfiles demográficos y prácticas clínicas. También buscan explorar cómo estos sesgos contribuyen a las desigualdades en la atención médica y en los resultados de salud.

Para los autores, el objetivo final es claro: desarrollar sistemas de inteligencia artificial que apoyen a los patólogos humanos de manera precisa y equitativa. “Creo que hay esperanza en que, si somos más conscientes y cuidadosos al diseñar sistemas de IA, podamos construir modelos que funcionen bien en todas las poblaciones”, concluyó Yu.