Los modelos de lenguaje recuerdo son capaces de realizar tareas como resumir o corregir textos, además de requerir menos potencia y memoria.

La inteligencia artificial (IA) generativa y los grandes modelos de lenguaje (LLM, en inglés) experimentaron un avance muy importante durante el último año. Modelos como GPT-4 pueden generar textos informativos y responder preguntas como lo haría un humano. Además, la capacidad de estos modelos para sintetizar y resumir información también está probada y cumplen esta tarea con eficiencia.

No obstante, los LLM tienen grandes capacidades debido a su alto costo y además tiene poco margen para su personalización. De esta manera, han emergido también los modelos de lenguaje reducido son versiones más compactas de los LLM. Estos modelos son menos complejos en términos de parámetros y capacidad de procesamiento, pero conservan la capacidad de entender y generar lenguaje de manera efectiva.

Se utilizan en aplicaciones donde los recursos computacionales son limitados, como en dispositivos móviles o entornos con menos capacidad de almacenamiento y poder de CPU. A pesar de su capacidad reducida y limitada, estos modelos siguen siendo útiles para tareas como corrección gramatical, sugerencia de texto, resúmenes automáticos y algunas aplicaciones de asistencia digital donde la complejidad de un modelo de lenguaje completo no es tan necesaria.

A continuación, algunos de los beneficios de esto tipo de modelo de lenguaje en comparación con los LLM:

- Eficiencia computacional: Al ser versiones más pequeñas, requieren menos recursos computacionales para funcionar. Esto es especialmente útil en dispositivos con capacidades limitadas, como teléfonos móviles o dispositivos móviles.

- Menor consumo de energía: La reducción en la complejidad también conlleva un menor consumo de energía, lo que puede ser crucial en dispositivos alimentados por batería.

- Rápido despliegue: Debido a su menor tamaño, estos modelos pueden desplegarse más rápidamente, facilitando su implementación en una variedad de entornos.

- Adecuados para tareas específicas: Son eficientes para tareas específicas como corrección gramatical, generación de texto simple, resúmenes automáticos, entre otras, donde no es necesaria la complejidad total de un modelo de lenguaje más grande.

- Menor requerimiento de almacenamiento: Al ocupar menos espacio, estos modelos son ideales para situaciones donde el almacenamiento es escaso.

- Mayor privacidad: Al procesar y almacenar menos información, los modelos reducidos pueden abordar preocupaciones de privacidad al reducir la cantidad de datos sensibles manejados por el modelo.

- Menos dependencia de la conectividad: Pueden ser más útiles en entornos con conectividad limitada, ya que suelen requerir menos interacción con servidores remotos para realizar tareas.

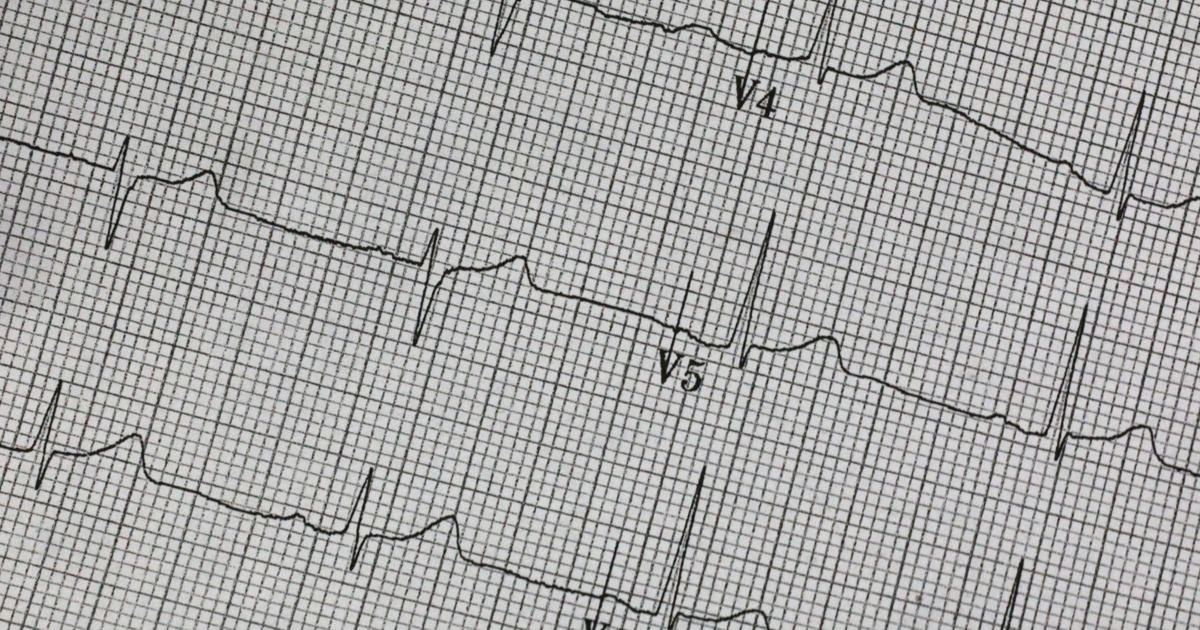

En este sentido, los modelos de lenguaje reducido ofrecen múltiples beneficios, especialmente en situaciones donde los recursos son limitados. Además, en el caso de la salud, pueden ser más útiles debido a su personalización a las necesidades de sus usuarios. Por ejemplo, se pueden desarrollar este tipo de modelos para responder preguntas sobre condiciones específicas, como enfermedades crónicas, cáncer, o sobre consejos nutricionales, entre otros usos.

MEDIUM/BIJIT GHOSH

ZDNET