El LLM, GPT-4 logró diagnosticar de manera correcta el 57% de los casos clínicos, superando al 99,98% de los lectores humanos simulados generados.

Investigadores de Dinamarca, evaluaron el rendimiento del modelo de inteligencia artificial (IA) de OpenAI, GPT-4 en el diagnóstico de casos médicos complejos y lo compararon con el porcentaje de aciertos con el de los lectores simulados de revistas médicas. En este sentido, GPT-4 logró diagnosticar correctamente el 57% de los casos, superando al 99,98% de los lectores humanos simulados generados a partir de respuestas en línea.

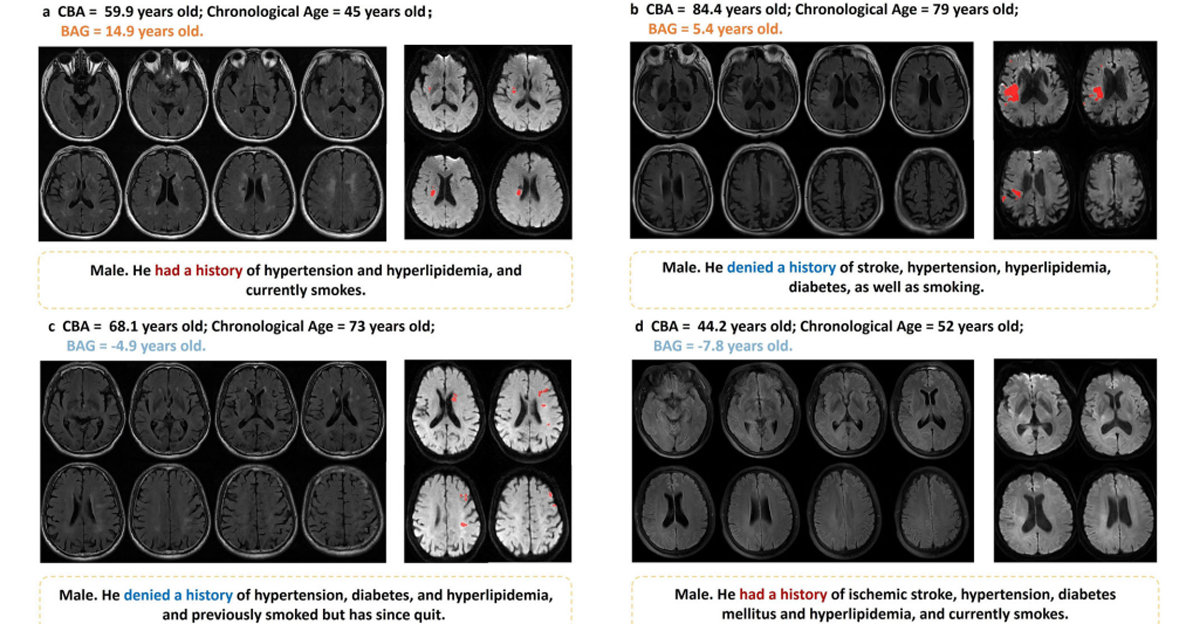

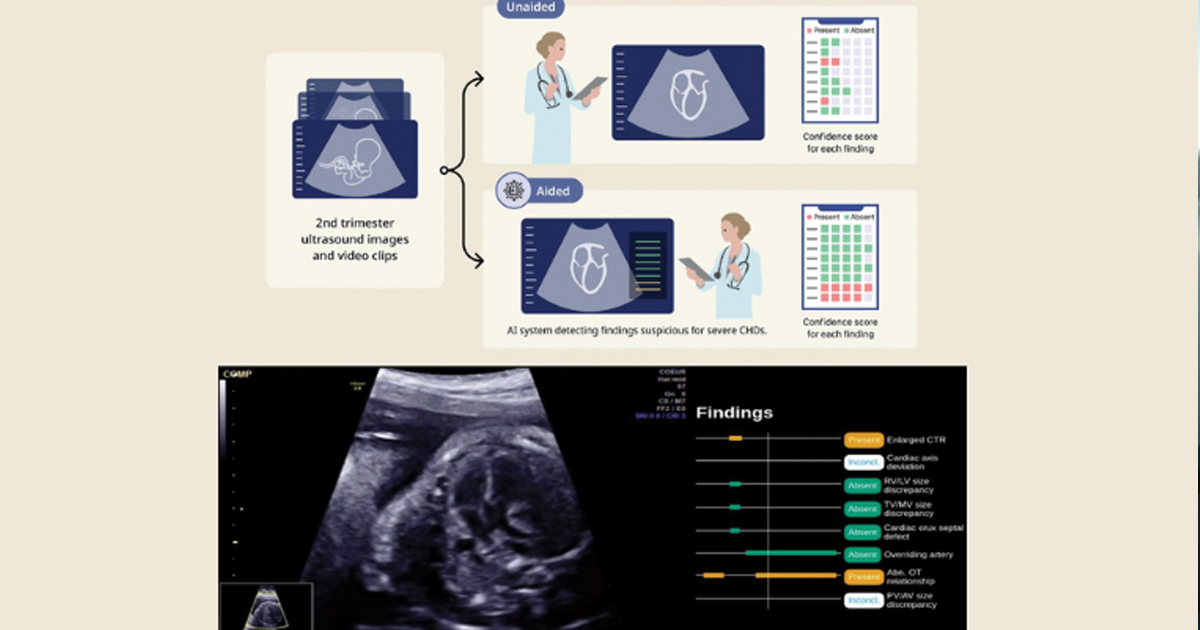

Los autores exponen que la escasez de médicos y el aumento de la complejidad en el campo de la medicina, es un reto importante para la tarea que muchos médicos enfrentan cada día: los diagnósticos oportunos y precisos. Debido a los cambios demográficos, con una población que envejece, la carga de trabajo es uno de los retos de la salud pública y que aumentará en el futuro gradualmente, es por ello que investigadores han resaltado la necesidad de aprovechar los nuevos desarrollos tecnológicos en la atención clínica. Por ejemplo, aunque la IA existe desde hace varias y ha demostrado grandes avances, en los últimos años ha crecido su adopción de manera meteórica. Por ejemplo, ha mostrado resultados prometedores en campos concretos de la medicina, como las imágenes médicas.

De esta manera, el continuo desarrollo de la IA, incluidos los grandes modelos de lenguaje (LLM, en inglés) han permitido la investigación en nuevas áreas. Por ejemplo, el conocido como Generative Preentrenado Generativo o GPT, ha permitido la generación de resúmenes de alta calidad y la generación de informes de pacientes. Recientemente, un artículo científico demostró que GPT-4 era capaz de responder correctamente a las preguntas del examen de licencia médica en Estados Unidos.

Sin embargo, existe cautela entre la comunidad médica sobre cómo funcionaría un LLM en casos clínicos reales. Es decir, no está claro hasta qué punto la GPT-4 puede ayudar en casos clínicos que contienen descripciones largas, complicadas y variadas de los pacientes, y cuál es su función en estos casos complejos del mundo real en comparación con los especialistas humanos.

Los autores del estudio evaluaron el rendimiento de GPT-4 en casos médicos reales comparando su rendimiento con el de los lectores de revistas médicas. El estudio utilizó desafíos de casos clínicos complejos disponibles con información completa a texto completo publicados en línea entre enero de 2017 y enero de 2023. Cada caso presenta un historial médico y una encuesta con seis opciones para el diagnóstico más probable. Además, para resolver los desafíos de casos, le proporcionaron a GPT-4 una instrucción o prompt y un caso clínico.

Lorem ipsum dolor sit amet, consectetur adipiscing elit. Ut elit tellus, luctus nec ullamcorper mattis, pulvinar dapibus leo.

El número de diagnósticos correctos entre los 38 casos que se produjeron por azar fue de 6,3 (16,7%) de acuerdo con las seis opciones de la encuesta. La edición de marzo de 2023 de GPT-4 logró diagnosticar correctamente una media de 21,8 casos (57%) con una buena reproducibilidad mientras que los lectores de revistas médicas diagnosticaron correctamente una media de 13,7 casos (36%). En este sentido, de acuerdo con la simulación los autores descubrieron que GPT-4 obtuvo mejores resultados que el 99,98% de la “pseudopoblación” de lectores generada para el estudio.

Sin embargo, esta es una de las limitaciones más importantes del estudio: el uso de una población mal caracterizada de lectores humanos de revistas con niveles desconocidos de conocimientos médicos. No obstante, explican los autores “incluso en el caso extremo de una correlación máxima de respuestas correctas entre los lectores de revistas médicas, GPT4 obtendría mejores resultados que el 72% de los lectores humanos”.

Finalmente, los investigadores destacaron el potencial de la IA como una gran herramienta de apoyo para diagnósticos, sin embargo, antes de adoptar su aplicación clínica es necesario trabajar en nuevas mejoras, como validar y abordar consideraciones éticas.