Investigadores de la Universidad de Boston presentaron MedSyn el primer modelo de IA generativa consciente de la anatomía y con el potencial de múltiples aplicaciones en imágenes médicas.

Uno de los primeros modelos de inteligencia artificial (IA) generativa de imágenes fue DeepDream, desarrollado por Google en 2015. Aunque no era exactamente un modelo generativo como los que conocemos actualmente, DeepDream utilizaba redes neuronales convolucionales para “soñar” o alterar imágenes preexistentes, creando resultados visuales surrealistas y psicodélicos.

Otros avances importantes ocurrieron a través de los modelos Generative Adversarial Networks (GANs), que constan de dos redes neuronales que compiten entre sí: una genera imágenes, el generador y la otra las evalúa, el discriminador, lo que llevó a avances importantes en la creación de imágenes sintéticas relativamente realistas.

Finalmente, las tecnologías más recientes como DALL-E y Stable Diffusion han perfeccionado el uso de modelos de lenguaje (LLM, en inglés) y redes neuronales para generar imágenes a partir de descripciones textuales, también llamados prompts, esto marcó un avance importante en la generación automática de imágenes a un nivel mucho más detallado y con niveles de realismo significativamente mayores.

Los modelos de IA generativa utilizan algoritmos de machine learning que contienen grandes datasets para el análisis de imágenes y patrones, lo cual permite la reconstrucción de imágenes.

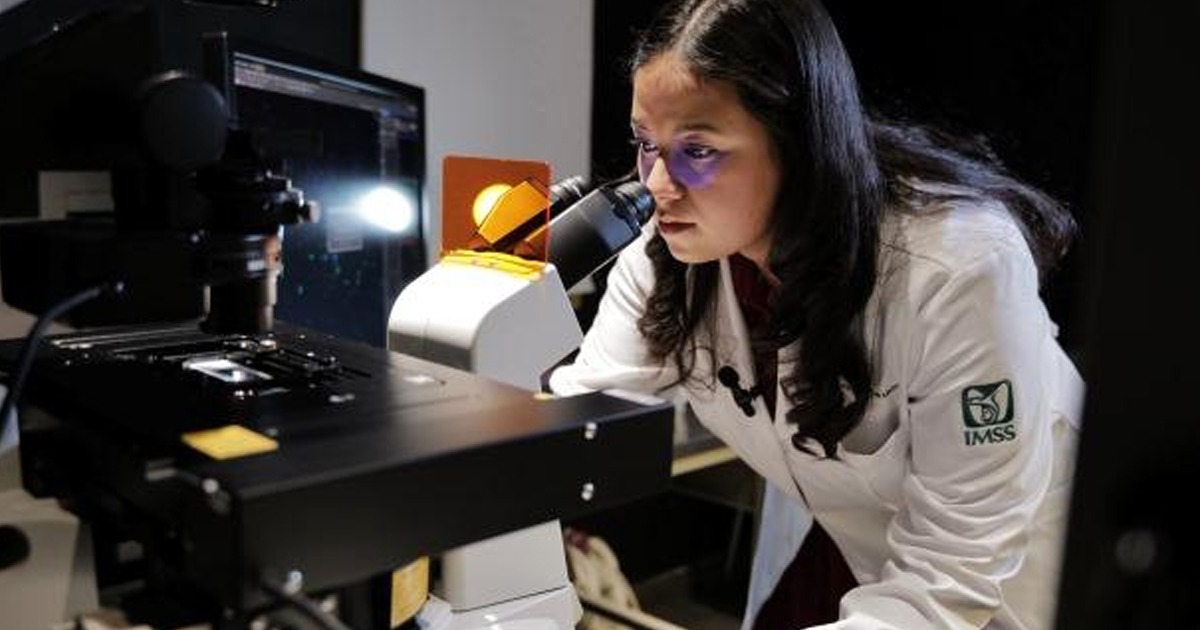

En cuando a imágenes médicas, los modelos impulsados por IA pueden ser utilizados para detectar patrones, por ejemplo, en imágenes de rayos X o tomografías computarizadas, lo cual ayuda a mejorar diagnósticos de distintas enfermedades.

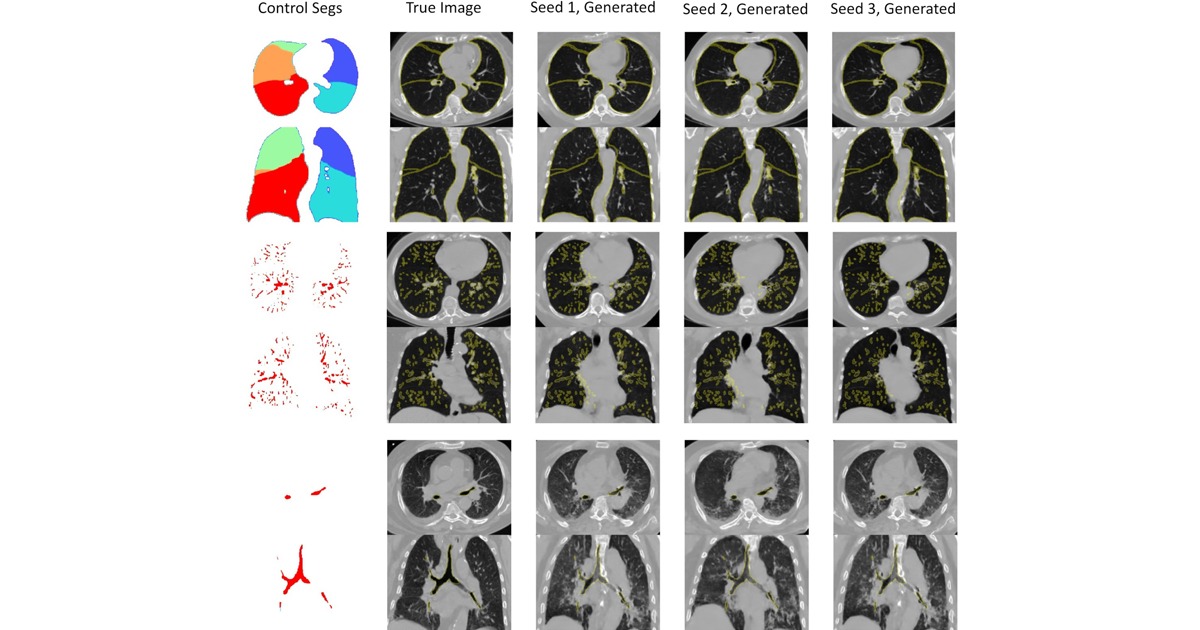

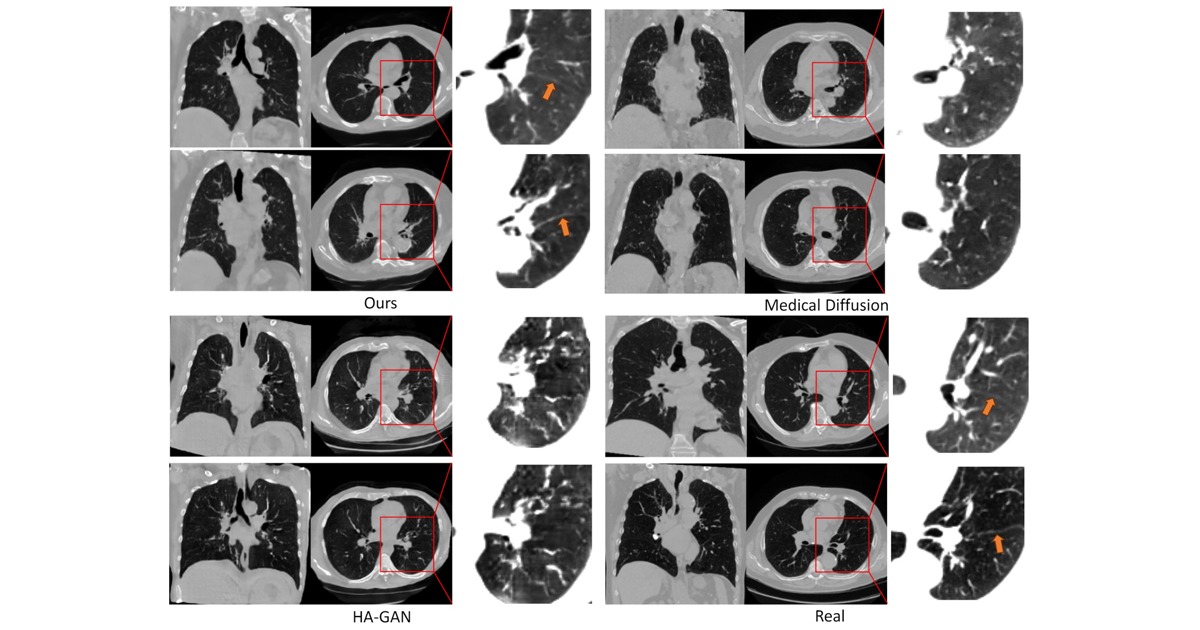

Sin embargo, el uso de IA generativa para imágenes médicas en un tema poco explorado, en un artículo publicado recientemente en IEEE Transactions on Medical Imaging, por investigadores de la Universidad de Boston, se presenta un enfoque único para la obtención de imágenes médicas mediante IA. Según explican los autores, se trata del primer modelo de IA generativa consciente de la anatomía y ha demostrado producir con eficacia imágenes volumétricas (3D) de tomografía computarizada de tórax de gran precisión utilizando indicaciones de texto o prompts.

Este modelo denominado MedSyn, promete ser una potente herramienta con diversas aplicaciones clínicas y de investigación. En ecosistemas clínicos, MedSyn puede ser utilizado para interpretar anormalidades complejas y detectar enfermedades con altos niveles de precisión y eficiencia.

“Aunque la tendencia de los modelos fundacionales ha sido adoptar un enfoque único para todos los casos, no creemos que sea la mejor práctica para las imágenes médicas”, expresó Kayhan Batmanghelich, autor del estudio y profesor adjunto de ingeniería en Universidad de Boston. “Los cambios patológicos en la anatomía pueden producirse años antes de que se manifieste la enfermedad. Para que las intervenciones tengan el mayor impacto posible, necesitamos modelos de IA sofisticados que puedan detectar anomalías que a menudo son difíciles de detectar en las fases más tempranas de la progresión de la enfermedad”, agregó.

MedSyn adopta un enfoque multimodal específico para cada órgano, de tal manera que los algoritmos del modelo se entrenan con un gran conjunto de datos de más de 9 mil tomografías de tórax en 3D emparejadas con más de 200 mil informes radiológicos anónimos. Así, a través de aprender información detallada el modelo proporciona un control preciso sobre la generación de imágenes.

“Al ajustar específicamente el modelo de lenguaje de IA al lenguaje utilizado en los informes radiológicos e incorporar restricciones que imponen posiciones anatómicas estándar coherentes con el cuerpo humano, nuestro modelo puede sintetizar imágenes con un nivel de granularidad, incluso cuando se presentan detalles anatómicos pequeños y difíciles de ver”, expresó Batmanghelich.

La IA continúa demostrando su potencial para revolucionar la atención médica, sin embargo, todavía hay escepticismo por parte de muchos profesionales debido a problemas o desafíos relacionados con la limitación de los datos de entrenamiento o la falta de transparencia.

“Como el conjunto de datos de MedSyn procede de tomografías e informes radiológicos, el resultado es totalmente transparente y tan interpretable como un informe radiológico”, declaró Batmanghelich. “La herramienta no sólo facilita la labor de los médicos, sino que los investigadores pueden utilizar este método como base de sus investigaciones”.

Esta investigación representa un gran paso adelante al demostrar las capacidades y el impacto potencial de desarrollar IA generativa capaz de desarrollar modelos fundacionales anatómicamente específicos. El código preentrenado de esta investigación está disponible de manera abierta en el siguiente enlace: https://github.com/batmanlab/MedSyn

BOSTON UNIVERSITY

https://www.bu.edu/hic/2024/08/06/lung-disease-anatomy-aware-ai-genai-bu/

MACHINE LEARNING MASTERY

https://machinelearningmastery.com/what-are-generative-adversarial-networks-gans/

IONOS